La Casa Blanca presiona a la industria tecnológica para cerrar el mercado de deepfakes AI abusivos sexualmente

La administración del presidente Joe Biden está presionando a la industria tecnológica e instituciones financieras para cerrar un creciente mercado de imágenes sexuales abusivas creadas con tecnología de inteligencia artificial.

Las nuevas herramientas de inteligencia artificial generativa han facilitado la transformación de la apariencia de alguien en un deepfake AI sexualmente explícito y compartir esas imágenes realistas en salas de chat o redes sociales. Las víctimas, ya sean celebridades o niños, tienen poco recurso para detenerlo.

La Casa Blanca está lanzando un llamado el jueves en busca de cooperación voluntaria de las empresas en ausencia de legislación federal. Al comprometerse con un conjunto de medidas específicas, los funcionarios esperan que el sector privado pueda frenar la creación, propagación y monetización de imágenes AI no consensuadas, incluidas imágenes explícitas de niños.

“A medida que la inteligencia artificial generativa irrumpió en escena, todos especulaban sobre dónde vendrían los primeros daños reales. Y creo que tenemos la respuesta,” dijo Arati Prabhakar, asesora científica principal de Biden y directora de la Oficina de Política de Ciencia y Tecnología de la Casa Blanca.

Ella describió al Associated Press una “aceleración fenomenal” de las imágenes no consensuadas impulsadas por herramientas de inteligencia artificial y que apuntan principalmente a mujeres y niñas de una manera que puede trastornar sus vidas.

“Si eres una adolescente, si eres un niño gay, estos son problemas que la gente está experimentando en este momento,” dijo. “Hemos visto una aceleración debido a la inteligencia artificial generativa que se está moviendo muy rápido. Y lo más rápido que puede suceder es que las empresas den un paso adelante y asuman la responsabilidad.”

Un documento compartido con AP antes de su lanzamiento el jueves pide acción no solo a los desarrolladores de IA sino también a los procesadores de pagos, instituciones financieras, proveedores de computación en la nube, motores de búsqueda y a los guardianes, en particular Apple y Google, que controlan lo que llega a las tiendas de aplicaciones móviles.

El sector privado debería dar un paso adelante para “disruptir la monetización” del abuso sexual basado en imágenes, restringiendo el acceso al pago especialmente a sitios que publicitan imágenes explícitas de menores, dijo la administración.

Prabhakar dijo que muchas plataformas de pago e instituciones financieras ya dicen que no apoyarán los tipos de negocios que promueven imágenes abusivas.

“Pero a veces no se hace cumplir; a veces no tienen esos términos de servicio,” dijo. “Y eso es un ejemplo de algo que se podría hacer de manera mucho más rigurosa.”

Los proveedores de servicios en la nube y las tiendas de aplicaciones móviles también podrían “reducir los servicios web y aplicaciones móviles que se comercializan con el propósito de crear o alterar imágenes sexuales sin el consentimiento de las personas,” dice el documento.

Y ya sea generado por IA o una foto desnuda real publicada en internet, los sobrevivientes deberían poder obtener más fácilmente que las plataformas en línea las eliminen.

La víctima más conocida de imágenes deepfake pornográficas es Taylor Swift, cuya ferviente base de fanáticos luchó en enero cuando comenzaron a circular imágenes AI generadas abusivas de la cantautora en redes sociales. Microsoft prometió reforzar sus medidas de seguridad después de que algunas de las imágenes de Swift se rastrearon hasta su herramienta de diseño visual de IA.

Un número creciente de escuelas en Estados Unidos y en otros lugares también están lidiando con deepfakes de desnudos generados por IA que representan a sus estudiantes. En algunos casos, se descubrió que compañeros adolescentes estaban creando imágenes manipuladas por IA y compartiéndolas con compañeros de clase.

El verano pasado, la administración Biden negoció compromisos voluntarios con Amazon, Google, Meta, Microsoft y otras importantes empresas tecnológicas para colocar una serie de salvaguardias en nuevos sistemas de IA antes de liberarlos al público.

Esto fue seguido por Biden firmando una ambiciosa orden ejecutiva en octubre diseñada para dirigir cómo se desarrolla la IA para que las empresas puedan obtener ganancias sin poner en peligro la seguridad pública. Si bien se centró en preocupaciones más amplias sobre la IA, incluida la seguridad nacional, asintió al problema emergente de imágenes de abuso infantil generadas por IA y en encontrar mejores maneras de detectarlo.

Pero Biden también dijo que las salvaguardias de IA de la administración necesitarían ser respaldadas por legislación. Un grupo bipartidista de senadores de Estados Unidos está presionando al Congreso para gastar al menos 32 mil millones de dólares en los próximos tres años para desarrollar inteligencia artificial y financiar medidas para guiarla de manera segura, aunque en gran medida ha postergado los llamados para promulgar esas salvaguardias en ley.

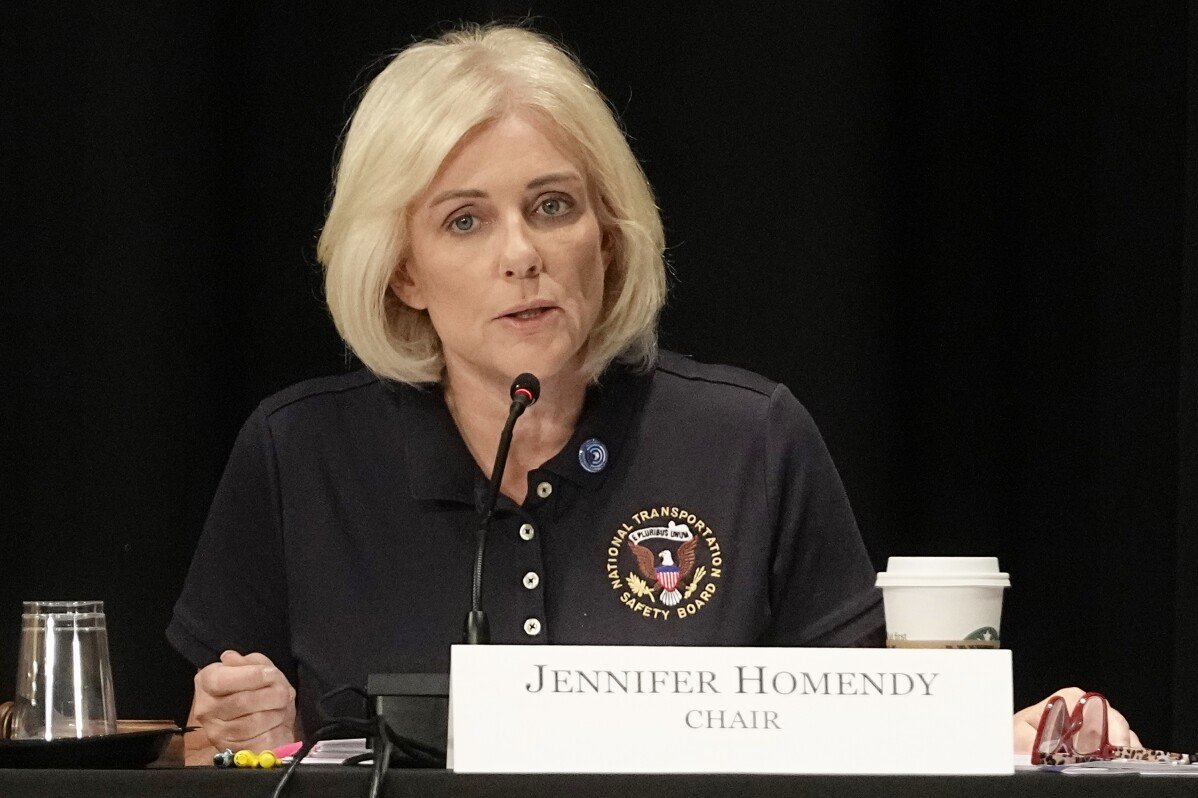

Alentar a las empresas a dar un paso adelante y hacer compromisos voluntarios “no cambia la necesidad subyacente de que el Congreso tome medidas aquí,” dijo Jennifer Klein, directora del Consejo de Política de Género de la Casa Blanca.

Las leyes de larga data ya criminalizan la creación y posesión de imágenes sexuales de niños, incluso si son falsas. Los fiscales federales presentaron cargos a principios de este mes contra un hombre de Wisconsin al que dijeron que usó un popular generador de imágenes de IA, Stable Diffusion, para crear miles de imágenes realistas generadas por IA de menores involucrados en conductas sexuales. Un abogado del hombre declinó hacer comentarios después de su audiencia de acusación el miércoles.

Pero casi no hay supervisión sobre las herramientas y servicios tecnológicos que hacen posible crear tales imágenes. Algunas se encuentran en sitios web comerciales de poca duración que revelan poca información sobre quién los administra o la tecnología en la que se basan.

El Observatorio de Internet de Stanford dijo en diciembre que encontró miles de imágenes de abuso sexual infantil sospechosas en la gigantesca base de datos de IA LAION, un índice de imágenes y leyendas en línea que ha sido utilizado para entrenar a los principales fabricantes de imágenes de IA como Stable Diffusion.

Stability AI con sede en Londres, propietaria de las últimas versiones de Stable Diffusion, dijo esta semana que “no aprobó la liberación” del modelo anterior supuestamente utilizado por el hombre de Wisconsin. Tales modelos de código abierto, porque sus componentes técnicos se publican públicamente en internet, son difíciles de contener.

Prabhakar dijo que no es solo la tecnología de IA de código abierto la que está causando daño.

“Es un problema más amplio,” dijo. “Desafortunadamente, esta es una categoría que muchas personas parecen estar utilizando para los generadores de imágenes. Y es un lugar donde simplemente hemos visto una explosión. Pero creo que no se puede dividir fácilmente entre sistemas de código abierto y propietarios.”

——

El escritor de AP Josh Boak contribuyó a este informe.